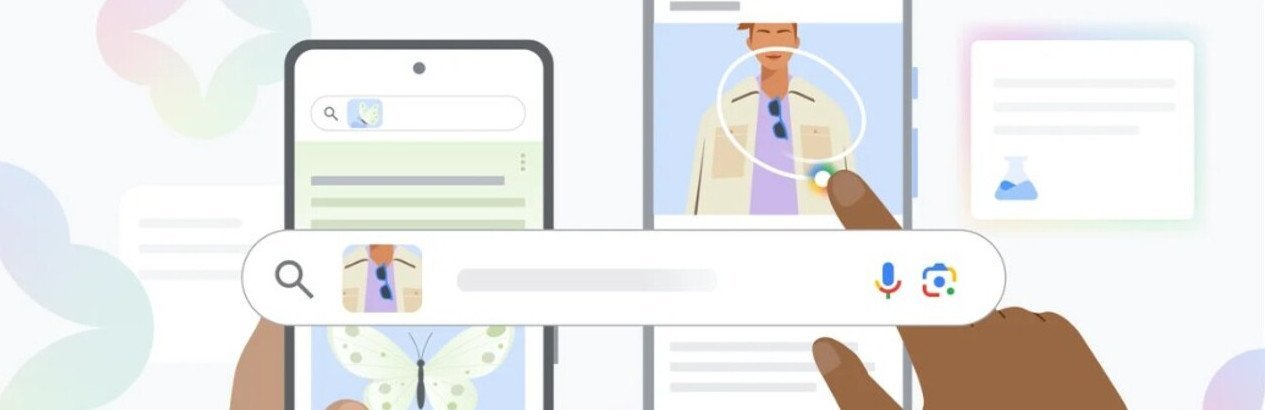

Uma atualização recente do Google introduziu no Android uma função que converte qualquer elemento exibido no visor do celular em porta de entrada para conhecimento. O recurso, apresentado pela empresa como um novo estágio de pesquisa visual, possibilita ao usuário descobrir produtos, lugares ou termos em diferentes idiomas simplesmente desenhando um círculo, rabisco ou realizando um toque sobre a imagem. A inteligência artificial integrada identifica o objeto selecionado, exibe resultados na mesma tela e elimina a dependência de descrições textuais elaboradas.

Quem ganha com a mudança e o que realmente foi anunciado

O anúncio parte do princípio de tornar a navegação cotidiana mais transparente. Em vez de alternar entre aplicativos, copiar endereços de internet ou digitar descrições aproximadas, o usuário passa a acionar a pesquisa de maneira direta, em qualquer contexto visual. Roupas vistas numa rede social, gadgets destacados em um vídeo ou um monumento presente em foto de viagem convertem-se em consultas instantâneas. O ganho de praticidade se estende a compradores em plataformas de e-commerce, turistas que desejam identificar pontos de interesse e pessoas que precisam traduzir um cardápio estrangeiro sem selecionar texto.

Quando e onde o recurso entra em ação

A facilidade já está embutida no sistema operacional Android. Basta manter o botão de início — ou a barra de navegação — pressionado por alguns segundos dentro de qualquer aplicativo ativo. Não é necessário abrir o app de busca nem recorrer a atalhos externos; o ambiente visual onde a pessoa está permanece inalterado, reduzindo o atrito entre a curiosidade e a resposta.

Como iniciar a pesquisa passo a passo

1. Pressionar o botão de início ou a barra de navegação.

2. Aguardar o sinal de ativação do Google.

3. Circular, rabiscar ou simplesmente tocar sobre a área de interesse da imagem.

4. Visualizar a resposta numa aba sobreposta, sem abandonar o conteúdo que estava sendo consumido.

O procedimento inteiro ocorre em poucos segundos, dispensando digitação ou seleção prévia de campos de texto.

Por que o gesto de circular simplifica a experiência

Antes da novidade, o caminho padrão exigia redigir palavras-chave na esperança de que o mecanismo de busca interpretasse corretamente a descrição. Termos como “sapato azul com fivela dourada” ou “torre antiga com relógio perto de um rio” nem sempre levavam ao resultado exato. O reconhecimento visual orientado por IA suprime essa etapa: ele interpreta cores, formas e texturas para estabelecer correspondência direta entre a imagem capturada na tela e informações disponíveis na internet.

Resposta sobreposta e navegação sem interrupção

Assim que o usuário completa o gesto, os resultados surgem em uma janela flutuante. Esse painel contém links, imagens adicionais e, quando relevante, traduções. A decisão de sobrepor a resposta — em vez de redirecionar a pessoa a outro aplicativo — mantém intacta a linha de raciocínio. Caso seja necessário voltar ao conteúdo original, basta fechar a janela e continuar de onde se parou.

Variações de uso demonstradas pela empresa

O Google listou cenários práticos que ressaltam a versatilidade da ferramenta:

• Identificação de monumentos e pontos turísticos em fotografias postadas em redes sociais, informando localização, história e horários de visitação.

• Busca por produtos específicos exibidos em vitrine virtual ou anúncio, permitindo comparação de preços entre lojas online.

• Tradução de trechos de texto em quadros de vídeo, embalagens ou cardápios, sem que seja preciso copiar e colar o conteúdo.

Comparativo entre o método convencional e a nova solução

Entrada de dados

Tradicional: digitação de palavras-chave.

Circule para Pesquisar: interação gestual diretamente na imagem.

Agilidade

Tradicional: alternância entre aplicativos, barras de endereço e campos de texto.

Circule para Pesquisar: ativação instantânea sobre qualquer app ativo.

Imagem: inteligência artificial

Precisão visual

Tradicional: dependência da descrição textual fornecida pelo usuário.

Circule para Pesquisar: análise baseada na imagem real exibida na tela.

A inteligência artificial por trás do reconhecimento contextual

A atualização explora modelos de IA aptos a compreender contexto visual sem instruções verbais. Esses modelos detectam contornos, padrões de cor e relações espaciais entre objetos, convertendo esses dados em consultas estruturadas no índice de busca do Google. O processo ocorre em tempo real, motivo pelo qual a empresa enfatiza a “resposta imediata” após o gesto. Embora os detalhes técnicos permaneçam restritos à comunicação institucional, fica claro que o algoritmo interpreta tanto forma quanto função do elemento selecionado, fornecendo resultados que combinam imagens correlacionadas e links explicativos.

Impacto na experiência geral do usuário

Ao reduzir cliques e telas intermediárias, o recurso eleva a rapidez da navegação móvel. Usuários deixam de interromper a leitura, a reprodução de vídeo ou a rolagem de um feed para alternar ao aplicativo de busca. A pesquisa torna-se invisível, pois ocorre no mesmo lugar onde a dúvida surgiu. Essa integração pode estimular consultas mais frequentes, já que o esforço necessário para obter respostas se aproxima de zero.

Ampliação do ecossistema de busca

Além do benefício imediato ao consumidor, a novidade reforça a presença do Google em todas as etapas de uso do smartphone. Qualquer aplicativo passa a ser, potencialmente, um ponto de coleta de dados de intenção, pois o gesto de circular recupera informações diretamente dos servidores de busca. Com isso, links úteis, resultados de compras e traduções são entregues de forma contínua, sem que o usuário perceba barreiras entre apps distintos.

Consequências práticas para diferentes perfis de usuário

Consumidores online ganham um comparador embutido na tela, útil para avaliar preços sem abrir novas guias.

Viajantes têm acesso imediato a detalhes sobre pontos turísticos captados em fotos e podem traduzir placas, cardápios ou sinais em tempo real.

Estudantes podem isolar trechos de texto em imagens para aprofundar pesquisas acadêmicas.

Como a novidade dialoga com limitações anteriores

Análises anteriores mostravam que descrições textuais nem sempre captavam nuances de cor, textura ou estilo. A IA, ao interpretar diretamente esses elementos visuais, contorna equívocos gerados por vocabulário impreciso ou desconhecimento dos nomes corretos de determinadas peças, espécies ou monumentos. O resultado é uma taxa maior de acerto, percepção de utilidade instantânea e menos frustração na busca.

Onde se encaixa a função dentro do Android

Por operar via botão de início ou barra de navegação, o recurso se integra ao núcleo do sistema, não a um aplicativo isolado. Essa implementação sistêmica garante acessibilidade constante, independentemente do fabricante ou da interface gráfica instalada, desde que o dispositivo execute a versão de Android contemplada pela atualização.

Visão geral do fluxo de uso

1. Usuário encontra um item de interesse em foto, vídeo ou página.

2. Mantém botão de início pressionado.

3. Desenha um contorno no objeto desejado.

4. IA do Google interpreta o fragmento visual.

5. Painel flutuante exibe resultados organizados em imagens, links e textos descritivos.

6. Usuário interage com a informação sem fechar o aplicativo original.

Relevância para o futuro da pesquisa móvel

A simplificação agora oferecida sinaliza a tendência de tornar a busca tão natural quanto o próprio ato de olhar a tela. Se hoje basta circular um objeto para receber dados, é plausível imaginar que gestos ainda mais simples — sempre no limite do que foi apresentado — continuem substituindo teclados virtuais em consultas rotineiras. Por ora, o avanço anunciado já representa um passo concreto na direção de interfaces mais fluídas e responsivas às necessidades imediatas do usuário.

Paulistano apaixonado por tecnologia e videojogos desde criança.

Transformei essa paixão em análises críticas e narrativas envolventes que exploram cada universo virtual.

No blog CELULAR NA MÃO, partilho críticas, guias e curiosidades, celebrando a comunidade gamer e tudo o que torna o mundo dos jogos e tecnologia tão fascinante.